VT2018 XXX: Difference between revisions

(→Titre) |

No edit summary |

||

| Line 10: | Line 10: | ||

=Abstract= |

=Abstract= |

||

Apache MXNet est un framework d'apprentissage profond léger, flexible et ultra-échelle qui supporte l'état de l'art des modèles d'apprentissage profond, y compris les réseaux neuronaux convolutifs (CNNs) et les réseaux de mémoire à long terme (LSTMs). |

|||

Évolutif |

|||

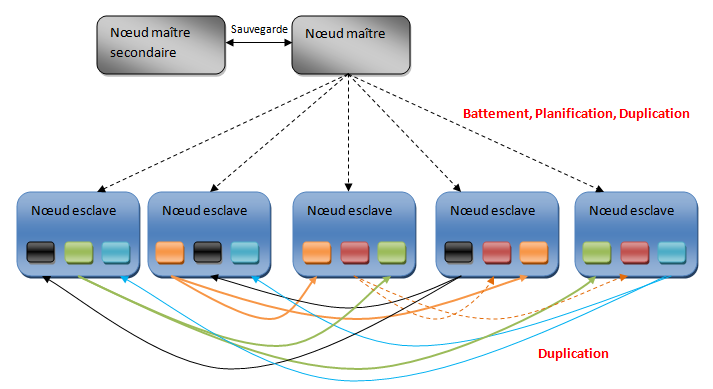

MXNet est conçu pour être distribué sur une infrastructure dynamique en nuage, en utilisant un serveur de paramètres distribués (basé sur des recherches de l'Université Carnegie Mellon, Baidu et Google[7]), et peut atteindre une échelle presque linéaire avec plusieurs GPU ou CPU. |

|||

Flexible |

|||

MXNet supporte à la fois la programmation impérative et symbolique, ce qui permet aux développeurs habitués à la programmation impérative de s'initier plus facilement à l'apprentissage approfondi. Il facilite également le suivi, le débogage, la sauvegarde des points de contrôle, la modification des hyperparamètres, tels que le taux d'apprentissage ou l'arrêt anticipé. |

|||

Langues multiples |

|||

Supporte C+++ pour le backend optimisé pour tirer le meilleur parti du GPU ou CPU disponible, et Python, R, Scala, Julia, Perl, MATLAB et JavaScript pour un frontend simple pour les développeurs. |

|||

Portable |

|||

Prise en charge d'un déploiement efficace d'un modèle formé à des appareils bas de gamme pour l'inférence, tels que les appareils mobiles (en utilisant Amalgamation[8]]), Internet of things devices (en utilisant AWS Greengrass), serverless computing (en utilisant AWS Lambda) ou conteneurs. Ces environnements bas de gamme ne peuvent avoir qu'un CPU plus faible ou une mémoire limitée (RAM), et devraient être capables d'utiliser les modèles qui ont été formés sur un environnement de niveau supérieur (cluster basé sur GPU, par exemple). |

|||

Voir aussi |

|||

Comparaison de logiciels d'apprentissage approfondi |

|||

Références et références |

|||

"Construire des réseaux neuronaux profon |

|||

Traduit avec www.DeepL.com/Translator |

|||

=Synthèse= |

=Synthèse= |

||

Revision as of 01:43, 19 November 2018

Apache Mxnet

Apache MXNet est un framework open-source de deep learning, utilisé pour former et déployer des réseaux neuronaux profonds. Il est évolutif, permettant une formation rapide aux modèles, et supporte un modèle de programmation flexible et de multiples langages de programmation (comme C++, Python, Julia, Matlab, JavaScript, Go, R, Scala, Perl, et Wolfram Language).

La bibliothèque MXNet est portable et peut évoluer vers plusieurs GPU et plusieurs machines. Le MXNet est soutenu par des fournisseurs publics de cloud computing, dont Amazon Web Services (AWS) et Microsoft Azure. Amazon a choisi le MXNet comme cadre d'apprentissage approfondi de choix chez AWS. Actuellement, le MXNet est soutenu par Intel, Dato, Baidu, Microsoft, Wolfram Research et des institutions de recherche comme Carnegie Mellon, MIT, University of Washington et la Hong Kong University of Science and Technology.

Résumé

Abstract

Apache MXNet est un framework d'apprentissage profond léger, flexible et ultra-échelle qui supporte l'état de l'art des modèles d'apprentissage profond, y compris les réseaux neuronaux convolutifs (CNNs) et les réseaux de mémoire à long terme (LSTMs). Évolutif

MXNet est conçu pour être distribué sur une infrastructure dynamique en nuage, en utilisant un serveur de paramètres distribués (basé sur des recherches de l'Université Carnegie Mellon, Baidu et Google[7]), et peut atteindre une échelle presque linéaire avec plusieurs GPU ou CPU. Flexible

MXNet supporte à la fois la programmation impérative et symbolique, ce qui permet aux développeurs habitués à la programmation impérative de s'initier plus facilement à l'apprentissage approfondi. Il facilite également le suivi, le débogage, la sauvegarde des points de contrôle, la modification des hyperparamètres, tels que le taux d'apprentissage ou l'arrêt anticipé. Langues multiples

Supporte C+++ pour le backend optimisé pour tirer le meilleur parti du GPU ou CPU disponible, et Python, R, Scala, Julia, Perl, MATLAB et JavaScript pour un frontend simple pour les développeurs. Portable

Prise en charge d'un déploiement efficace d'un modèle formé à des appareils bas de gamme pour l'inférence, tels que les appareils mobiles (en utilisant Amalgamation[8]]), Internet of things devices (en utilisant AWS Greengrass), serverless computing (en utilisant AWS Lambda) ou conteneurs. Ces environnements bas de gamme ne peuvent avoir qu'un CPU plus faible ou une mémoire limitée (RAM), et devraient être capables d'utiliser les modèles qui ont été formés sur un environnement de niveau supérieur (cluster basé sur GPU, par exemple). Voir aussi

Comparaison de logiciels d'apprentissage approfondi

Références et références

"Construire des réseaux neuronaux profon

Traduit avec www.DeepL.com/Translator