ECOM2016 LaReleve - Deploiement

Déploiements

Ayant 5 machines à disposition, nous avons mis en place le déploiement suivant :

On trouve dans ce déploiement : - front-LaReleve : le client de notre application angular frontend - deux HaProxy : un proxy permettant un load balancing entre deux instances de API-LaReleve - deux API-LaReleve : notre API JEE - deux Mysql-GR : Conteneur stockant notre base de donnée et mis en lien pour que leurs contenus ne diffèrent jamais (une opération dans une base implique la mise à jour de l'autre) - Hawkular services - Cassandra - Grafana

Composition docker

Sur chaque machines, uniquement des conteneur docker sont exécuté. Pour les contrôles facilement, des compositions docket ont donc été décrites. Voici ces compositions et les fichiers de configuration nécessaires à leurs fonctionnement :

ECOM-1 et ECOM-2

Sur les serveurs ECOM-1 et ECOM-2 se trouvent un conteneur HAPROXY effectuant un load balancing sur deux serveur executant API-LaReleve. Effectuant du ssh, un script generate.sh a été créé pour créer facilement des certificats auto-signés. Les deux machines exécutent exactement les mêmes conteneurs et ont exactement la même configuration. Seul les certificats pour effectuer du http sont différents puisqu'il sont associé aux noms de domains liés au machine ECOM-1 et ECOM-2.

docker-compose.yml

version: '2'

services:

haproxy:

image: 'haproxy:latest'

ports:

- '443:443'

volumes:

- './haproxy/etc/ssl:/etc/ssl'

- './haproxy/usr/local/etc/haproxy:/usr/local/etc/haproxy'

- './haproxy/dev/log:/dev/log'

generate.sh

#!/bin/bash

mkdir -p haproxy/etc/ssl

# Certs

openssl genrsa -out haproxy/etc/ssl/air.key 2048

openssl req -new -key haproxy/etc/ssl/air.key -multivalue-rdn -subj "/C=FR/L=GRENOBLE/O=UGA/O=POLYTECH/OU=RICM/CN=AIR/emailAddress=air@imag.fr" -out haproxy/etc/ssl/air.csr

openssl x509 -req -days 365 -in haproxy/etc/ssl/air.csr -signkey haproxy/etc/ssl/air.key -out haproxy/etc/ssl/air.crt

cat haproxy/etc/ssl/air.crt haproxy/etc/ssl/air.key | tee haproxy/etc/ssl/air.pem

# Dhparam

openssl dhparam -out haproxy/etc/ssl/dhparam.pem 2048

haproxy/usr/local/etc/haproxy/haproxy.cfg

global

log /dev/log local0

log /dev/log local1 notice

chroot /root/

stats socket /var/run/haproxy.sock mode 660 level admin

stats timeout 30s

daemon

# Default ciphers to use on SSL-enabled listening sockets.

# For more information, see ciphers(1SSL). This list is from:

# https://hynek.me/articles/hardening-your-web-servers-ssl-ciphers/

ssl-default-bind-ciphers ECDH+AESGCM:DH+AESGCM:ECDH+AES256:DH+AES256:ECDH+AES128:DH+AES:ECDH+3DES:DH+3DES:RSA+AESGCM:RSA+AES:RSA+3DES:!aNULL:!MD5:!DSS

ssl-default-bind-options no-sslv3

defaults

# log global

mode http

option httplog

option dontlognull

timeout connect 5000

timeout client 50000

timeout server 50000

frontend localhost

bind *:80

mode http

default_backend nodes

frontend localhostS

bind *:443 ssl crt /etc/ssl/air.pem

mode http

default_backend nodes

# JavaEE servers are javaee01 and javaee02

backend nodes

mode http

balance roundrobin

option forwardfor

option httpchk HEAD / HTTP/1.1\r\nHost:localhost

server ecom03 ecom-3:8080 check

server ecom04 ecom-4:8080 check

http-request set-header X-Forwarded-Port %[dst_port]

http-request add-header X-Forwarded-Proto https if { ssl_fc }

ECOM-3 et ECOM-4

Sur les serveurs ECOM-3 et ECOM-4 se trouvent API-LaReleve et les base de données associés à chacune. Avec l'utilisation de l'image docker Mysql-GR et la mise en place de paramètres dans la commande de lancement du conteneurs, les bases de données sont configurés en Group Replication. Cela veut dire que si une action est effectué sur une des deux bases, elle est immédiatement répliquer sur l'autre.

Les noeuds sont lancés exactement de la même manière. Il faut pour cela récupéré le projet API-Runtime (dépot) et lancer la composition après avoir configuré les variables d'environnement et la commande de lancement du conteneur mysql-gr.

docker-compose.yml

version: '2'

services:

wildfly:

image: gattazr/lareleve:latest

ports:

- '8080:8080'

- '9990:9990'

environment:

JAVA_OPTS: '-server -Xms64m -Xmx512m -XX:MetaspaceSize=96M -XX:MaxMetaspaceSize=256m -Djava.net.preferIPv4Stack=true -Djboss.modules.system.pkgs=org.jboss.byteman -Djava.awt.headless=true -Dcom.sun.jersey.server.impl.cdi.lookupExtensionInBeanManager=true'

#### Wildfly administration

# ACTIVATE_ADMIN: 1

# ADMIN_USERNAME: 'admin'

# ADMIN_PASSWORD: 'admin123456'

#### Mysql

# MYSQL_HOST: 'mysqldb:3306'

# MYSQL_DATABASE: 'lareleve'

# MYSQL_USER: 'lareleve'

# MYSQL_PASSWORD: 'lareleve123'

#### Hawkular

# HAWKULAR_HOST: '192.168.99.100:8080'

# HAWKULAR_USERNAME: 'jdoe'

# HAWKULAR_PASSWORD: 'password'

volumes:

- ./data/wildfly/log:/opt/jboss/wildfly/standalone/log

# - ./data/wildfly/deployments/:/opt/jboss/wildfly/standalone/deployments/

mysqldb:

image: 'mysql/mysql-gr:latest'

ports:

- '3306:3306'

- '6606:6606'

environment:

MYSQL_DATABASE: 'lareleve'

MYSQL_USER: 'lareleve'

MYSQL_PASSWORD: 'lareleve123'

MYSQL_ROOT_PASSWORD: 'mysqldb123'

MYSQL_REPLICATION_USER: 'rpl_user'

MYSQL_REPLICATION_PASSWORD: 'rpl_pass'

volumes:

- ./schema.sql:/docker-entrypoint-initdb.d/schema.sql:ro

- mysqlVolume:/var/lib/mysql

command: sh -c '/entrypoint.sh --group_replication_group_seeds="" --server-id=1'

# command: sh -c '/entrypoint.sh --group_replication_group_seeds="ecom4:6606" --server-id=1'

# command: sh -c '/entrypoint.sh --group_replication_group_seeds="ecom3:6606" --server-id=2'

volumes:

mysqlVolume:

driver: local

Remarque : Les variables HAWKULAR_HOST, HAWKULAR_USERNAME, HAWKULAR_PASSWORD lié au conteneur wildfly sont des variables permettant le monitoring du conteneur. Si elles ne sont pas mise en place, aucun monitoring n'est effectué. Dans le cas contraire, elles doivent désigner un serveur hawkular-services avec des accès fonctionnels. Dans notre cas, il s'agit de la seconde composition se trouvant sur ECOM-5. Notez que Hawkular-services doit être lancé avant la création du conteneur wildfly.

ECOM-5

Sur ECOM-5 se trouve deux compositions. La première est très simple et permet de mettre en place . La second est légèrement plus complexe et permet la mise en place d'un système de monitoring de wildfly et donc des conteneurs API-LaReleve.

frontend/docker-compose.yml

version: '2'

services:

frontal:

image: 'gattazr/lareleve-front:latest'

ports:

- '80:80'

grafana/docker-compose.yml

version: '2'

services:

grafana:

image: 'welshstew/hawkular-metrics-grafana'

ports:

- '3000:3000'

cassandra:

image: 'cassandra:3.7'

environment:

CASSANDRA_START_RPC: 'true'

hawkular:

image: 'hawkularqe/hawkular-services:latest'

ports:

- '8080:8080'

environment:

TEST_MODE: 'true'

JAVA_OPTS: '-server -Xms64m -Xmx512m -XX:MetaspaceSize=96M -XX:MaxMetaspaceSize=256m -Djava.net.preferIPv4Stack=true -Djboss.modules.system.pkgs=org.jboss.byteman -Djava.awt.headless=true -Dcom.sun.jersey.server.impl.cdi.lookupExtensionInBeanManager=true'

DB_TIMEOUT: 180

CASSANDRA_NODES: 'cassandra'

HAWKULAR_USERNAME: 'jdoe'

HAWKULAR_PASSWORD: 'password'

Les Complications

Ressources

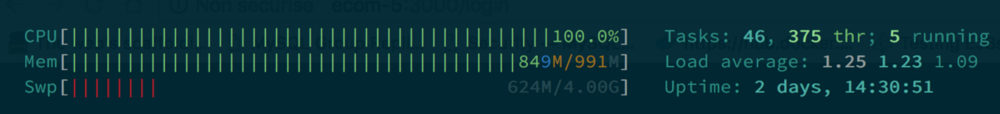

Les machines que nous avons manipulés pendant ce projet ont des ressources très limités. Notamment en mémoire. De ce fait, il peut être intéressant de mettre en place des partitions de SWAP si ce n'est pas des partitions présentes.

Les commandes suivantes permettent la création d'une partition de SWAP de 4Go.

/bin/dd if=/dev/zero of=/var/swap.1 bs=1M count=1024

/sbin/mkswap /var/swap.1

chmod 600 /var/swap.1

/sbin/swapon /var/swap.1

Réseaux

Suivant les machines utilisés pour faire ce déploiement, des problèmes peuvent apparaitre pour joindre une machine ou une autre. La présence de proxy devant les machines ECOM-3 et ECOM-4 peuvent par exemple amener des problèmes. Aussi, pour faire fonctionner certains services, il peut être nécessaire qu'une certaine topologie réseaux soit mise en place.

L'exemple le plus flagrant vient des machines ECOM-3 et ECOM-4. La réplication de la base de donnée avec MySQL Group Replication (mysql-gr) nécessite que ces deux machines se trouvent sur un même réseau local.